Les réseaux d’entreprise sont si complexes à administrer que les trous dans la raquette sont inévitables. La tentation est grande de multiplier à l’envi des solutions cyber pour combler des lacunes en matière de sécurité. Bénéficiant du soutien du Thales Digital Factory, le programme d’incubation du groupe, la spin-off Chimere propose une nouvelle façon de concevoir les réseaux et de penser la sécurité périmétrique.

Largement déployé de nos jours, le principe de la sécurité périmétrique consiste à découper les réseaux en interne en zones distinctes et de configurer les pare-feux de façon à ce qu’ils n’autorisent que les flux considérés comme valides (et qui ne sont donc pas considérés comme des menaces) par la politique de sécurité du réseau. Mais dans de nombreux cas, les attaquants sont capables d’outrepasser ces blocages en usurpant des adresses IP autorisées ou en effectuant des attaques de l’homme du milieu. Créée en novembre 2022, la spin-off Chimere s’appuie sur une démarche totalement Zero-Trust d’accès réseau. Entretien avec Guillaume-Alexandre Chaizy-Gostovitch et Gabriel Ladet, les deux cofondateurs.

Pouvez-vous vous présenter ainsi que votre startup ? Quel est votre lien avec le groupe Thales et la Thales Digital Factory ?

Nous sommes deux ingénieurs en cybersécurité, issus du groupe Thales. Nous avons travaillé cinq années pour la société pendant lesquelles nous sommes intervenus chez des clients de toutes tailles et de tous secteurs pour les assister sur leurs problématiques de sécurité. Guillaume-Alexandre a également travaillé sur l’offre Blockchain de Thales, tandis que j’intervenais sur les questions de sécurité offensive et la réalisation de pentests.

Au cours de nos missions, nous avons accompagné de nombreux clients victimes de compromission. Nos analyses post-mortem ont révélé des vecteurs d’attaque récurrents malgré l’application des bonnes pratiques en matière de sécurité.

Dans de nombreux cas, ils n’étaient pas à blâmer.

Lorsqu’un attaquant pénètre un réseau en exploitant une vulnérabilité Zero-day sur une passerelle VPN exposée sur Internet, il est difficile de justifier une faute dans l’application d’un process, ou du patch management. Les réseaux d’entreprise sont si complexes à administrer que les trous dans la raquette sont inévitables. C’est sans compter le fait qu’ils s’appuient sur des protocoles aussi anciens qu’Internet, et misent sur des successions de solutions cyber pour combler leurs lacunes en matière de sécurité.

Nous nous sommes ainsi demandé s’il n’y avait pas quelque chose à changer dans la manière dont on appréhendait la sécurité aujourd’hui. Est-ce que les solutions que nous employons sont réellement adaptées aux menaces actuelles ?

En parallèle de nos missions, nous avons expérimenté un certain nombre de façons d’aborder le sujet. On a essayé de faire abstraction des pratiques et des recommandations actuelles en termes d’architecture réseaux ou d’accès distant sécurisé. Cette gymnastique n’est jamais évidente : sortir du cadre dans lequel on est habitué à évoluer, c’est un peu comme apprendre de nouveau à marcher.

Cependant, après plusieurs semaines de recherche et une première preuve de concept, nous avons réalisé que nous détenions peut-être quelque chose d’intéressant. Nous avons présenté l’idée au sein d’un concours interne de Thales, qui nous a permis d’obtenir un premier financement.

Après une phase supplémentaire de R&D, on nous a recommandé de candidater au Start-Up Studio de la Thales Digital Factory : le programme d’incubation du groupe.

C’est à partir de ce moment que Chimere est réellement née. Cet accompagnement de haute qualité nous a permis d’atteindre ce que nous n’aurions pas pu faire seuls. Cette remise à plat de nos connaissances techniques était maintenant suivie d’une remise en perspective totale de tous les aspects avec lesquels nous, ingénieurs techniques, n’étions pas familiers : business, marketing, proposition de valeur, pitch ou finances.

Pendant trois mois intenses, nous avons été amenés à tester notre proposition de valeur sur le marché et avons réalisé que l’idée que nous avions identifiée initialement pouvait peut-être s’inscrire dans une vision plus large et plus percutante. Nous avons pivoté sur notre approche, obtenu des premiers partenaires grands comptes pour nous suivre dans l’aventure puis avons pitché auprès des hautes instances Thales pour l’obtention du financement qui a, par la suite, permis de recruter les six membres de l’équipe, développer la solution et obtenir le MVP que nous avons actuellement.

Wannacry : 300 000 machines infectées en 4 jours

Afin de nous permettre d’aller plus vite, Chimere est devenue une entité légale à part entière en novembre 2022. Bien sûr, nous continuons d’être soutenus par Thales et la Thales Digital Factory qui suivent de près nos avancements et sont toujours de bon conseil. Le fait que le projet soit né chez Thales marque de manière durable notre façon de penser et la manière dont nous abordons les problématiques de sécurité.

Nous tirons parti de cette expérience et les réflexes acquis au sein du groupe se reflètent dans notre façon de penser et d’agir au quotidien.

Pouvez-vous présenter le projet Chimere et la technologie sous-jacente ? Quels sont les aspects innovants, voire disruptifs en termes de sécurité ?

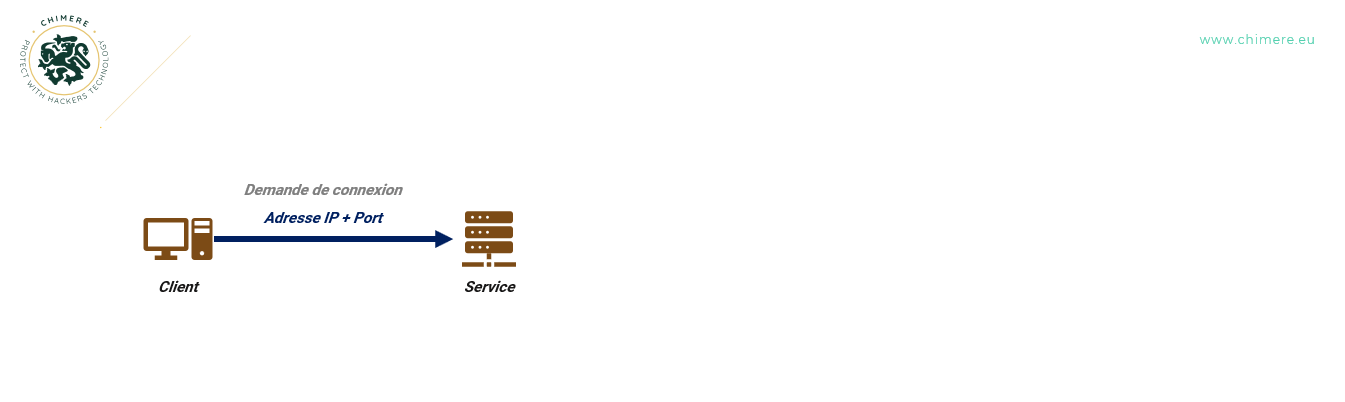

Chimere est une façon innovante de concevoir la sécurité réseaux, la notion de périmètre, de confiance et l’exposition des services sur Internet. Lorsqu’Internet a vu le jour dans les années 80, il s’agissait d’un réseau de confiance dans lequel tous les utilisateurs pouvaient espérer communiquer sans craintes. TCP/IP a même été conçu sur ce postulat : aujourd’hui encore, n’importe qui peut publier un service sur le réseau et le rendre accessible à l’intégralité des utilisateurs à travers une adresse IP et un port. La connaissance de ces deux informations est suffisante pour établir une connexion avec le service associé.

Lorsqu’Internet s’est étendu, et qu’il est devenu mondial, les cyber-menaces sont apparues face à ce modèle qui n’avait pas été conçu pour y faire face. Les attaquants scannent en permanence le réseau, découvrent des services vulnérables, puis les compromettent en utilisant des identifiants qu’ils ont récupérés via une fuite de données, du hameçonnage, ou en exploitant une vulnérabilité.

Ce principe est loin d’être nouveau, il suffit de revenir en 1988 avec le ver Morris pour se rendre compte qu’il s’inscrit dans le fondement même d’Internet. Cette menace, ayant reçu à l’époque une bonne couverture médiatique, exploitait des vulnérabilités dans les services de sendmail et fingerd exposés sur Internet. De façon automatisée, le ver scannait le réseau, détectait les services puis les infectait avant de continuer sa progression.

Presque 30 ans plus tard, en 2017, le ver Wannacry utilise le même procédé, en exploitant une vulnérabilité affectant les services SMB exposés sur Internet, et en se répliquant automatiquement. En quatre jours, plus de 300 000 machines sont infectées et le rançongiciel devient mondialement connu.

Cette problématique n’est pas réservée qu’à Internet. Les réseaux privés, fondés sur les mêmes protocoles de communication sont encore plus touchés. D’une part, les organisations considèrent que la confiance qu’il est possible d’accorder à un utilisateur à l’intérieur du réseau est supérieure à celle que l’on peut accorder à un utilisateur à l’extérieur. D’autre part, certaines attaques (MITM, IP Spoofing, TCP session hijacking) sont beaucoup plus aisément réalisables à l’intérieur d’un réseau privé que depuis Internet, donnant aux attaquants internes des armes supplémentaires.

Ainsi, il est d’usage de découper les réseaux internes en zones distinctes, dépendantes de la confiance qui leur est accordée, en employant des pare-feux qui auront pour rôle de n’autoriser que les flux considérés comme valides par la politique de sécurité du réseau. Ce principe de sécurité périmétrique est largement employé aujourd’hui.

Souvent, les pare-feux sont employés pour segmenter finement les accès aux services et ainsi s’assurer que seuls certains postes ou machines ne peuvent accéder qu’à des services précis. Les règles de filtrage se basent sur le quatuor historique de TCP/IP : l’adresse IP source, le port source, l’adresse IP de destination et le port de destination.

Dans de nombreux cas, les attaquants sont en réalité capables d’outrepasser ces blocages en usurpant des adresses IP autorisées ou en effectuant des attaques de l’homme du milieu. Au sein d’une même zone de confiance, il est souvent aisé pour eux de réaliser des mouvements latéraux et de prendre possession de machines supplémentaires pour faciliter les rebonds ailleurs dans le réseau.

Faire confiance à l’intermédiaire

Bien sûr, l’ajout de toujours plus de mécanismes et de solutions de sécurité vient alimenter le principe de défense en profondeur. En aucun cas nous ne renions ce principe fondamental.

Nous envisageons simplement une nouvelle façon de concevoir les réseaux et de penser la sécurité périmétrique.

Lorsque nous avons commencé à réfléchir à Chimere, il nous a semblé évident de nous focaliser sur l’un des premiers mécanismes offerts par TCP/IP : le principe d’exposition des services.

Avec TCP/IP, le service est en écoute sur une interface réseau, et est sollicité par un client qui demande l’établissement d’une connexion. On considère que le service est dans un état « passif », c’est-à-dire qu’il accepte les connexions des clients à partir du moment où ceux-ci connaissent l’adresse IP et le port associé.

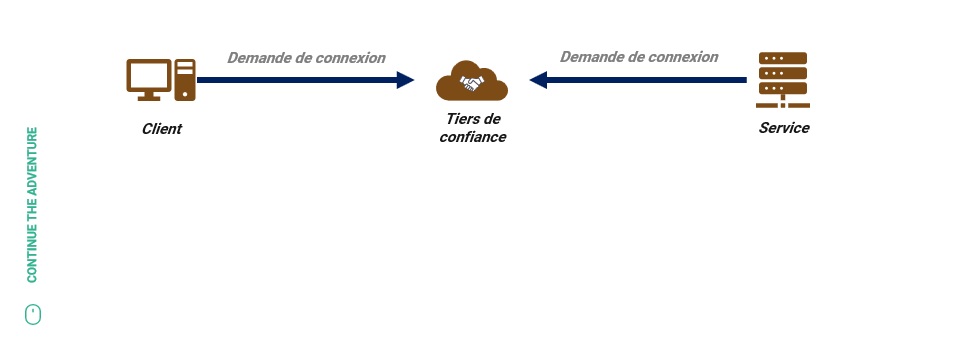

Le premier changement de paradigme a consisté à changer ce mécanisme. Afin d’éviter les scans réseau sauvages, il faut empêcher le service d’être en écoute et d’accepter par défaut les connexions qui lui sont demandées par les clients. De manière évidente, et toujours en se basant sur TCP/IP, il existe une façon naïve de régler ce problème : il suffit d’introduire un acteur tiers de confiance sur le réseau qui servira à interconnecter les utilisateurs et le service :

D’une part, les clients établissent une connexion vers le tiers de confiance, comme ils pouvaient le faire auparavant avec le service. D’autre part, le service établit une connexion avec le tiers de confiance. Ce dernier a ainsi le rôle d’interconnecter clients et service. On rajoute également une couche de chiffrement entre chaque acteur pour éviter les problèmes usuels de confidentialité.

Lorsque l’on considère le client et le service final, les flux TCP deviennent ainsi exclusivement sortants (en tous cas à l’établissement de la connexion, bien évidemment les messages transitent de façon bidirectionnelle). Le service peut ainsi éviter d’être en écoute sur une interface réseau accessible par des acteurs malveillants et n’est plus détectable par des scans sauvages d’attaquants.

Cependant, ce modèle introduit un nouveau problème : il faut faire confiance à l’intermédiaire.

Si ce dernier vient à être compromis, l’attaquant peut ainsi établir une connexion avec le service. Il peut, également, provoquer un déni de service en rendant l’intermédiaire indisponible. Et s’il n’existe pas de chiffrement de bout-en-bout, il peut espionner les conversations. Tout ça, sans évidemment oublier que l’intermédiaire est lui-même un service exposé, car il doit accepter les connexions en provenance des clients, mais également des services.

Finalement, ce modèle n’est-il pas qu’une façon de déplacer le problème ?

Il l’est, si l’intermédiaire ne dispose pas de certaines propriétés indispensables.

Imaginez que ce nouveau système présente les caractéristiques suivantes :

- Il doit être possible de ne pas avoir à faire confiance à l’intermédiaire sur l’aspect « confidentialité des messages » qui transitent à travers lui. Il ne doit pas être capable de lire les messages entre les clients et le service. Cet aspect est le plus simple à réaliser : il suffit d’intégrer un mécanisme de chiffrement de bout-en-bout.

- Il doit être possible de ne pas avoir à faire confiance à l’intermédiaire pour l’aspect « accès au service ». C’est-à-dire que celui-ci ne doit pas être capable d’établir de connexion avec le service qui est rendu disponible à travers lui. Seuls les clients autorisés doivent le pouvoir (par exemple, à l’aide d’un élément cryptographique).

- Il doit être possible de ne pas avoir à faire confiance à l’intermédiaire pour la disponibilité. On peut, par exemple, répartir la responsabilité de la disponibilité de l’intermédiaire entre plusieurs acteurs et organisations. Étant données les deux caractéristiques précédentes, cette fonctionnalité est envisageable puisqu’aucun des acteurs ne sera en mesure de lire le contenu des messages ou d’accéder aux services sans l’élément cryptographique adéquat.

Ces caractéristiques permettent même à l’intermédiaire d’être exposé sur Internet, sans porter atteinte à la sécurité des services rendus accessibles.

Si ces trois conditions sont réunies, alors le modèle prend tout son sens : il s’inscrit dans une démarche totalement Zero-Trust d’accès réseau. Il existe, d’ailleurs, un terme pour un tel modèle, inventé par Gartner en 2019 : le ZTNA (Zero-Trust Network Access).